| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |

- 직장인자기계발

- 독서리뷰

- 상관분석

- Ai

- 패스트캠퍼스후기

- EDA

- correlation

- API

- airflow

- 자동매매프로그램

- 리뷰

- 빅데이터

- 방콕여행

- Python

- 데이터

- 분석

- 패스트캠퍼스

- 패캠챌린지

- 데이터분석

- DAGs

- 태국여행

- 에어플로

- 머신러닝

- 데이터 분석

- 챗지피티

- 파이썬을활용한시계열데이터분석A-Z올인원패키지

- 파이썬

- 활성화함수

- 직장인인강

- 딥러닝

- Today

- Total

데이터를 기반으로

패스트캠퍼스 챌린지 37일차 본문

오늘의 강의는 어제의 마지막 부분에 GBM을 이어 진행되었다.

앙상블은 CLT와 잔차진단을 함께 적용되는 알고리즘이라고 보면된다.

마지막 Boosting은 bias 를 줄이기 위해 과적합이 사라지긴 어려운 단점이 있다. 예전 강의에서 Variance와 Bias는 반비례 관계이기에 각각을 가장 적당하 만족하는 중간 점을 찾는 것이 중요하다는 강의가 있었다.

결론적으로 Variance를 줄이기 위해서는 CLT를 Bias를 줄이기 위해서는 Residual을 이용한다고 보면 된다.

이렇게가 저번 강의와 이어지는 강의 내용이고 오늘은 분석 실습을 통해 데이터 마이닝 레퍼런스 알고리즘들의 성능을 확인해보는 시간을 가져봤다.

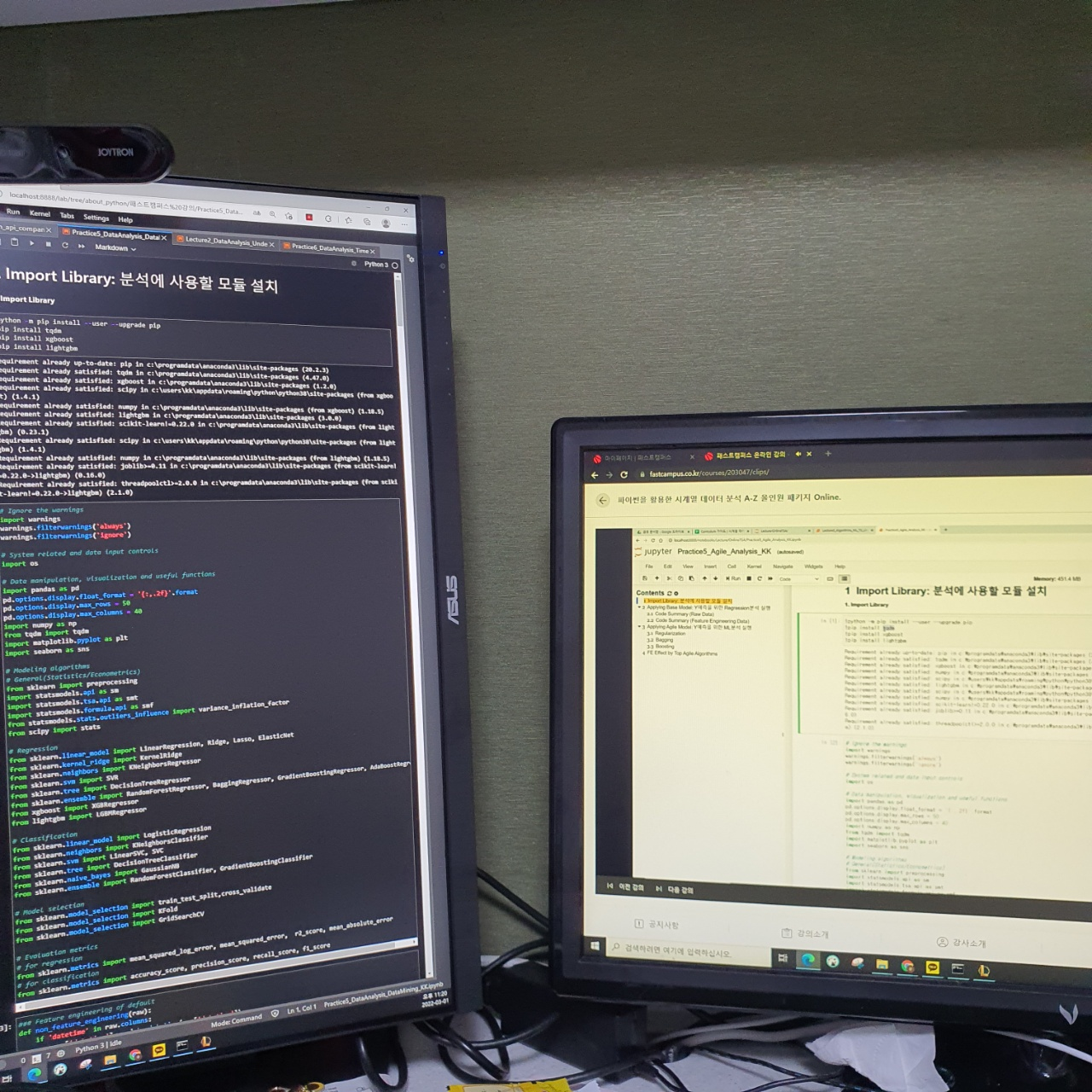

왼쪽 화면은 강의 자료화면이고 오른쪽은 강의 화면이다.

코드들이 꽤 긴데 이러한 코드들을 하나의 함수로 만들어서 패키지처럼 사용할 수 있는 법을 강사님께서 알려주었다.

방법은 먼저 해당 경로에 새로운 텍스트 파일을 만들고 해당 코드들을 그대로 한번에 대입해둔다. 이후 파일을 다른이름으로 저장하여 .py로 파일을 저장한다.

해당 경로에 저장하고 " from [파일명] import * " 이라는 코드로 불러올 수 있다.

이렇게 모든 함수들을 하나의 코드에 저장하여 모듈화하여 사용할 수 있다.

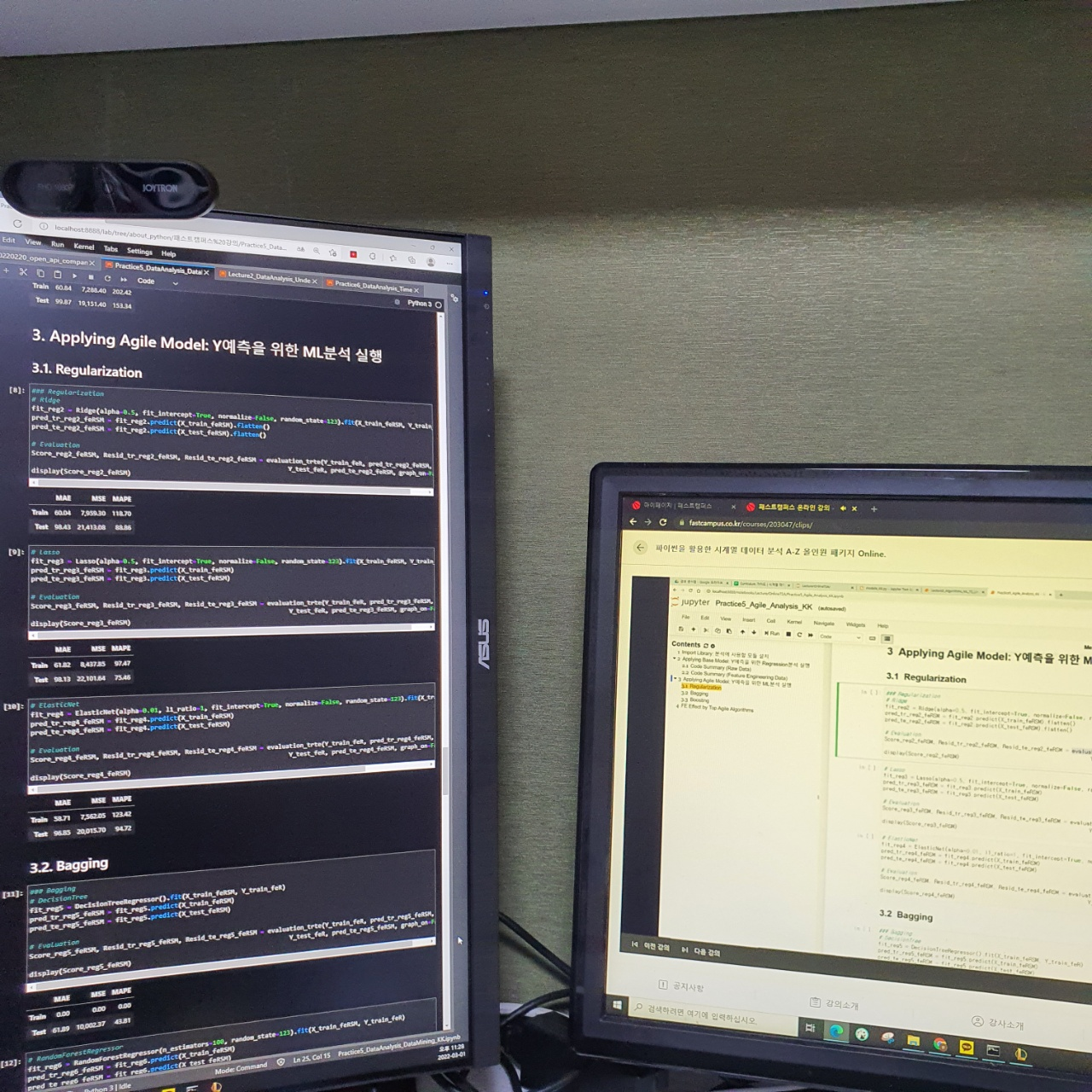

왼쪽 화면은 강의 자료화면이고 오른쪽은 강의 화면이다.

릿지, 라쏘, 엘라스틱넷 각각을 직접 구현하는 코드들이 실습 자료에 존재하였다.

Bagging은 DecisionTree Regressor와 RandomForest Regressor를 사용하였다. 기존에 릿지, 라쏘 등 회귀분석 보다 훨씬 더 높은 정확성이 나왔다.

Bagging 이후 정확도는 올라왔지만 과적합은 줄어드는 결과를 확인할 수 있었다.

Boosting은 Gradient Boosting Regressor와 XGBoost, LightGBM의 각각 Regressor를 사용하여 모델을 구축한 뒤 성능을 비교해 보았다.

XGBoost가 가장 좋은 정확도가 나왔지만 전체적인 평가지표를 고려할 때는 랜덤포레스트가 가장 좋은 모형으로 보여진다.

마지막에 피처 엔지니어링을 진행하지 않을 경우와 적용한 후의 결과를 각각 도출해보는 시도도 해보았다.

※ 본 포스팅은 패스트캠퍼스 환급 챌린지 참여를 위해 작성었습니다.

※ 관련 링크 : https://bit.ly/37BpXiC

'스터디 > 패스트캠퍼스' 카테고리의 다른 글

| 패스트캠퍼스 챌린지 39일차 (0) | 2022.03.03 |

|---|---|

| 패스트캠퍼스 챌린지 38일차 (0) | 2022.03.02 |

| 패스트캠퍼스 챌린지 36일차 (0) | 2022.02.28 |

| 패스트캠퍼스 챌린지 35일차 (0) | 2022.02.27 |

| 패스트캠퍼스 챌린지 34일차 (0) | 2022.02.26 |